Vor über nem Jahr schrieb ich einige Gedanken zum Stand von Voice Search auf und sammelte dazu eine Latte Links zu den bis dahin vorliegenden Daten. Letztere in erster Linie zur Verbreitung von Voicesearch und Mobile Search selber. These damals: ein großer Teil von Voicesearch-Anfragen, die mit eigenem Content beantwortet werden, wird man nie in Analytics-Tools oder Logfiles sehen, weil die Leute gar nicht erst auf die Webseite kommen.

Was seitdem geschrieben wurde, beschränkt sich meinem Eindruck nach auf Variationen von „Suchanfragen werden longtailiger“ (SEL, Forbes), „Die Zukunft spricht Structured® Data™“ (effektiv), „Local Signals rocken die Hütte“ (heise-regioconcept), das übliche „Speed. Speed, Speed, Mobiloptimierung und Speed sind die Lösung all unserer Probleme“ oder alles vom genannten (SEL). Das war damals nicht verkehrt und wirds auch heute nicht sein. Schlauer sind wir heute trotzdem nicht, und das liegt daran, dass wir von Google keine Daten kriegen. Also abseits von Statements der Art wie „xx% aller mobilen Suchanfragen sind schon Voice, tut was!“ Warnung vorab: es wird ein wenig verschwörerisch in Richtung „Google will da das Optimum für sich und nicht etwa für die Webmaster rausholen“ und ich spitze wie meist ein wenig zu, aber ich hab das Gefühl, der Aspekt war bisher eher unterbelichtet.

Wir sehen keine „spracheingabeartigen“ und auch nicht mehr longtailigere Suchanfragen als sonst in der Search Console, wir sehen sie schon gar nicht in Analytics und ich für meinen Teil seh sie auch nicht in anderen Logfile/Trafficanalysetools, die einem über den Weg laufen. Geschenkt, ich seh natürlich longtailige Suchanfragen, aber wer mir seriös sagen kann, was/wieviel davon Voice ist und was davon Google Suggest, ich wäre dankbar (hat mal wer die User Agents durchgesehen?1). Ansonsten gehe ich an sich davon aus, dass es a) Methode hat, dass man als Webmaster keinen erkennbaren Voicesearch-Traffic zu sehen bekommt und das b) denselben Hintergrund hat wie die Explosion an Featured Snippets die letzten Wochen und Monate. Korrigier mich wer, aber die Themen sah ich noch nicht verknüpft betrachtet und je länger ich drüber nachdenke, desto mehr denke ich, sie gehören durchaus ein gutes Stück weit zusammen.

Zur jüngsten Flut an Featured Snippets (ebbt grade ab, scheint mir) stell ich mir an sich gern vor, wie bei Google getestet wird, aus welchen Seiten man am besten zu welchen Themen welche Kurzinfos rausklaubt, auf Pos0 packt und dann nicht etwa guckt, wieviele Sprachsucher sich das vorlesen lassen: ich denke, okaye Daten kriegt man schon allein dadurch, wenn kein Suchergebnis mehr geklickt und nicht nach unten gescrollt wird. Unter den Kandidaten wird man ordentliches Antwortmaterial für Voicesearchanfragen gefunden haben. Und getestet wird da grade die ganze Zeit.

Das scheint mir an sich nicht im Interesse der Webmaster, denn der Optimalfall (für Google) ist ja, wenn nicht mehr geklickt werden muss. Wenns geklickt wird, ists offenbar kein optimales Featured-Snippet. Das sind Logiken/Metriken/KPIs, die ich nicht grade den Leuten auf die Nase binden würde, von denen ich den Content abgreife. Dazu passt auch gut, dass man es in Googles Führungsebene für „nicht zielführend“ hält, Webmastern da diesbezüglich beispielsweise in der Search Console Einsicht zu geben. Und deswegen werden wir keine kriegen, und Google kann sich wunderbar auf die Voice/Sprachassistentenzukunft einstellen.

Btw., auch für andere Voicesearch-Anfragen rechne ich auch weiterhin mit null, nada, niente Infos in Trackingtools und Referrern. Schauen wir uns die Datenströme einer Voicesearch mal an. Ich spreche was ins Smartphone/den Echo/Whatever. Wird dann die Phrase gegoogelt? Maximal „auch“ oder „teils“. Was ich ins Smartphone spreche, wird erst mal an Google/Apple/Amazon geschickt, die interpretieren das Soundfile und entscheiden, obs eine Geräteanweisung, eine direkte Frage oder was zum Googlen ist.2 In letzterem Fall nehme ich an, wird eine entsprechend aufbereitete Suchanfrage an die jeweilige Suchmaschine abgesetzt. Sinnvollerweise käme dazu noch ne Latte Metadaten bezüglich Gerät, Standort, vorhergegangene Fragen, was auch immer zum besseren Einschätzen meiner Suchintention notwendig ist. Das Suchergebnis sollte ein Resultat dieser Daten sein, und meine Vermutung ist, dass da die Reise hingehen wird.

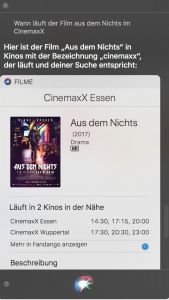

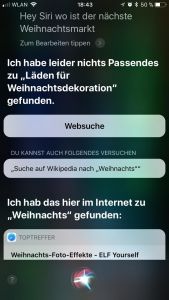

Sie ist aber nach wie vor am Anfang, wenns nicht grade um die gern genommenen Standard-Pizzabeispiele geht. Nebenstehend ein nettes Beispiel, dessen Suchresultate im Übrigen identisch mit der Google-Websuche sind. Ich habe begründete Zweifel, dass bei einer Suchanfrage namens „Weihnachts“ bei einem der gelisteten Seiten irgendwer „Ah, ne Voicesearch-Anfrage!“ ruft.

Ich bin abgeschwiffen. Mein Punkt zum letzten Absatz: was in den Assistenten gesprochen wird und was die eigentliche Term-Grundlage einer moglicherweise resultierenden Suchanfrage ist, hat nur bedingt was miteinander zu tun, auch und grade, wenns besser funktioniert als im nebenstehenden Patzer.

Die Gemeinsamkeit von Voicesearch-Suchanfragen und Featured-Snippet-Metriken ist meiner Ansicht nach, dass in beiden Fällen Google kein Interesse hat, Webmastern irgendwelche Daten darüber zu geben. Ich gehe davon aus, dass das damit zu tun hat, dass die Zielsetzungen eben nicht im Interesse de Webmaster sind (Google will gerade den Seiten keinen echten Besuchertraffic rüberschieben, die die besten Informationen in Featured Snippets-geeignetster Form anbieten) und man das den anfallenden Daten eben auch ansehen wird. Denken wir das analog mit Voicesearch und Sprachassistenten. Wenn ich meinem Echo sage, es soll mir das Apfelkuchenrezept vorlesen, wird es dann auch die Quelle vorlesen? Nachtrag 08.01: ja. Laut Quality Rater Guidelines lesen die Assistenten demnach ein „Laut (webseite) ist …“ vor. Gar die Werbebanner-Inhalte auf der Seite? Ich vermute mal nein. These: alles, was per Sprachausgabe aus dem Assistenten kommt, ist nicht mehr monetarisierbar. Nachtrag 08.01: ich denke, die Domainnennung entschärft das zugrundeliegende Problem allenfalls marginal.

Für die Pizzeria, wo man nach der vorgelesenen Speisekarte hinfährt oder den Lieferdienst scharfmacht, wirds Lampe sein. Ich denke aber, wer grade seine informationalen Angebote qualitativ hochwertig ausbaut, weil Content ja King ist, und sie schön featuredsnippet-fähig macht, weil Pos0 der neue heiße Scheiß ist, könnte gepflegt brechen, wenn das dann in zwei Jahren zu xx% vom Echo vorgelesen wird. Zugegeben, letzteres fällt mir schwer vorzustellen, aber ich versteh auch nicht, warum Leute Videos gucken, wenn sie schneller und leichter den Text lesen könnten.

Long Story Short: mir scheint, als seien hier zwei Entwicklungen in der Mache, die in erster Linie Google zugute kommen und in zweiter Linie den Usern. Für die Contentlieferanten siehts anders aus und deswegen werden sie keine Daten kriegen. Schlussschlenker: Über einen neuen Leistungsschutzrecht-Anlauf würde ich mich hingegen nicht wirklich wundern, wenn erst mal die FAZ-Headlines plus auf Kommando der Artikel automatisch und werbefrei vom Assistenten vorgelesen werden. Und wenn ich mich ganz weit aus dem Fenster lehnen wollen würde: Springer wirds wahrscheinlich als Begründung nehmen, auf der BILD dann gar keine Anzeigen mehr kenntlich zu machen, weil man wolle das ja eigentlich auch nicht, aber wird ja von Google quasi dazu gezwungen.

Mit Dank an Lasse, ohne den ich das wohl noch längere Zeit nicht endlich mal runtergetippt hätte.

1 Grade spontan gefunden: dweinstein über Amazon Echo Header, Connects, User Agents usw. Soweit ich sehe, nichts, was jetzt „raus“ an vom Echo angesurfte Seiten geht, aber genau sowas müsste man™ mal durchmessen.

2 Gehts nur mir so, oder ist das so einer der Elefanten im Raum der „Optimiert wegen Voice auf Fragen und Longtails“-Prediger, den alle gepflegt ignorieren?

2 Responses to Google Voice Search, Featured Snippets und ein paar Prognosen