Drin bevor „Aber Ruppsel, ‚den‘ Algorithmus gibts doch gar nicht?“, geschenkt. Und Widerspruch immer gerne, ich lern gern dazu und hab eh das Gefühl, die Branche hat ihre Tugend, wild über die Funktionsweise von Big G. zu spekulieren, in den letzten Jahren etwas vernachlässigt.

Wir sind erfreulich konkret geworden, wenns drum geht, es dem Algorithmus „recht zu machen“ – „Schnelles Rendern above the Fold!“ „Author/Article-Markup für besseres E-A-T“, WebP, NAP, ALTs nicht vergessen, selbst sowas wie „Hey, gute Seiten haben gelegentlich externe Links, hat John Mueller gesagt!“, das find ich persönlich sogar allerliebst. Und sowas les ich häufig. Aber wie „funktioniert“ „der“ „Algorithmus“? Ein paar Vermutungen und ein paar vermutete (und beobachtete) Nebenwirkungen.

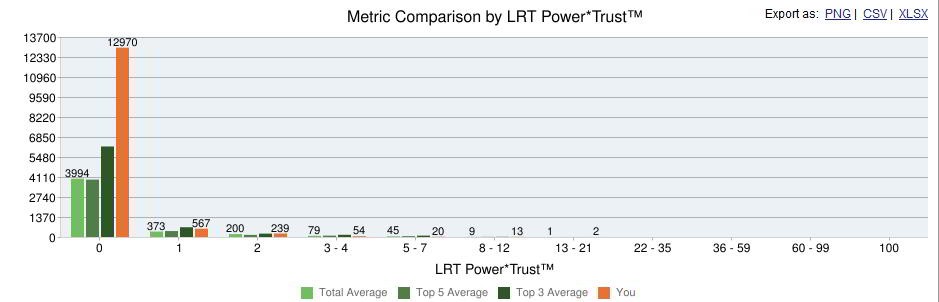

Früher(tm) gab es die berühmten „über x Signale“, die Google zur Bewertung einer Webseite heranzieht. Titles, H-Tags z.B. onpage, Time to first byte, Time to load z.B. technisch, Backlinks und deren Platzierung offsite usw. Alles zusammen ergibt irgendwas, daraus baut Google eine Bewertung der Seite.

Dann kamen MUM, Bert, RankBrain und wie sie alle hießen, nicht unbedingt in der Reihenfolge, und alle sind sie voll clever und machen die Googlesuche noch besser, schöner und aus Holz. Jedes Update seitdem mit großen Schritten zu besserem inhaltlichen, semantischen, intelligenten Verständnis, zu besseren Ergebnissen, vertrauenswürdigeren Daten und seriöseren Quellen.

Haha, nein. Vielmehr sehen wir bei jedem Core-Update eine Portion Seiten wieder besser werden, die vorher auf den Deckel kriegten und umgekehrt. Beim nächsten ähnlich. Im Großen und ganzen mag eine Tendenz erkennbar sein, aber hey, „iterativ“ ist da schon so ein Begriff, der mir in den Sinn kommt. Und ein wenig erinnert es mich an gaaaanz alte Zeiten, und wenn ich jetzt „Googledance“ sage und ein Kollege guckt dazu verwirrt: Glückwunsch, du kriegst die Klimakatastrophe noch voll ab.

Zum „Googledance“ änderten sich in alten, sehr alten Zeiten einmal wöchentlich die Rankings, und das meist sukzessive über die Rechenzentren weg. Das passierte, weil Google seinen Index neu bewertete, und das passierte halt jede Woche. Danach kamen irgendwann Caffeine und Everflux, seitdem gehts schneller bzw. andauernd. Bzw. halt, nein, seit irgendwann haben wir halt ein paar Core-Updates im Jahr.

Was passiert da? Offenbar was großes, kompliziertes, denn man kanns nicht eben mal nachkorrigieren, wenns durch ist. Und Google sagts sogar recht deutlich selber, wie ihr Prozedere da ist: sie trainieren ihre KI mit Daten über qualitativ hochwertige Websites. Was qualitativ hochwertig ist, lassen sie von ihren menschlichen Quality Ratern ermitteln. Anhand dieser Daten übt die KI ein, wie „qualitativ hochwertige“ Seiten aussehen, und basierend auf dem Trainingsergebnis werden die Seiten „in the wild“ dann klassifiziert.

Nun wird man sich das alles schon „so irgendwie“ gedacht haben, weitergedacht oder in den Konsequenzen mal auf die Wirklichkeit losgelassen kommt mir das aber eher selten unter. Und die Konsequenzen scheinen mir drastisch.

Ein Trainingsmodell für derart riesige Tasks ist nicht eben mal übers Wochenende in drei RZs verteilt erstellt, das ist *riesig*. Weiter ist das

· wenig wert ohne jeweils wieder bessere/aktuellere/aussagekräftigere Trainingsdaten, und das sind Daten von Menschen (den Quality Ratern), die erstellt, aktualisiert, bei neuen Webseiten/Suchergebnissen wieder erfasst werden müssen.

These, wie der Core-Update-Prozess schwerst pi mal daumen/grob vereinfach abläuft

· viele Qualityrater werden mit vielen aktuellen wie auch zeitlosen Google-Suchanfragen gefüttert und bewerten *händisch* die Ergebnisse der Googlesuche dahingehend, was (je nach Suchintention) „gute“ und was „schlechte“ Seiten sind (das dauert ne Weile, und die Datenbasis veraltet zwangsläüfig kontinuierlich)

· die Daten der Qualityrater werden – wahrscheinlich zusammen mit älteren, aber anders gewichteten, höheranteilig „zeitlosen“ Rater-Daten vorausgegangener Läufe kombiniert und zum Training der diversen Google-ML-Prozesse verwendet

· diese werden anhand der QR-Daten trainiert zu erkennen, wie „gute“ und wie „schlechte“ Seiten typischerweise aussehen.

· Wenn das Training weitgehend okaye Ergebnisse beim Einstufen bisher unbekannter Ergebnisseiten zeigt, wird das Ganze via Core-Update ausgerollt. D.h.,

· der neu generierte Bewertungsalgorithmus bewertet nun den Google-Gesamtindex neu (und auch das dauert nochmal die bekannten Tage bis Wochen).

In der Folge gibts neue SERPs, gewichtet anhand der neuen Bewertungsdaten der KI. Hinzu kommen „direkt maschinenlesbare“ Signale wie eben Ladezeiten, Linkstrukturen, klassische Onsitefaktoren usw.

Zwischen den Core-Updates wird Google wenig mehr justieren können als eben diese „direkt maschinenlesbaren“ Signale. Das ganze „Wie gut, vertrauenswürdig, für Suchintention X geeignet ist Seite X“-Gedöns hängt aber eben an KI-Trainingsdaten, die über einen längeren Zeitraum mit erheblichstem Menschen- und Rechenaufwand erstellt, trainiert und auf einen gigantischen Index losgelassen werden müssen.

Was ergibt sich daraus?

· John Mu kann sich zurücklehnen und sein übliches „Create great content“ antworten, wenn wer fragt, wie man gut rankt.

Denn: menschliche Quality Rater beurteilen Seiten dahingehend, ob sie zu Query X „great“ oder eher nicht-greaten Content anbieten. Was für die anschließend trainierte KI so aussieht wie eine „great content“-Seite, ist offenbar eine (bis zum nächsten Core-Update, jedenfalls).

· was einen dazwischen nach vorne oder nach hinten bringt, sind durchgehend andere, leichtgewichtigere (und vor allem „leichter erfassbare“) Kriterien.

Klar, Speed, Links, Semantik. Interne Struktur, und wer wie ich Google kein diesbezügliches Dementi glaubt: Nutzersignale. Und so weiter. Aber eben nicht die vielbeschworenen E-A-T- oder YMYL-Einstufungen. Denn um die neu zu justieren, muss Google erst mal wieder einen Algo trainieren.

· Wir haben wieder Googledances!

Nur halt ohne feste Termine und deutlich seltener als in den zweifellos hervorragenden Zeiten der Altvorderen. Am wichtigsten scheint mir aber:

· Google hat kaum mehr Einfluss auf die Suchergebnisse.

Tatsächlich scheint mir Google eine zentrale Instanz ihres Kernprodukts zu einer Blackbox gemacht zu haben. Auch für sie selber, und das ist so amüsant wie auch bemerkenswert. Ich bin recht sicher, dass Eingriffe in Suchergebnisrankings in den letzten Jahren massiv schwieriger geworden sind, und ebenso das klare Benennen der Faktoren, die eine „gute Seite“ ausmachen. Eine KI wird trainiert auf das Erkennen „guter Seiten zu Suche X“, und zum Training kriegt sie bekanntermaßen gute wie auch schlechte Ergebnisse zur Suche X. Naturgemäß sind die letztendlichen Beurteilungskriterien nicht mehr menschenlesbar, geschweige denn gezielt änderbar. Wenn das Rollout durch ist, gibts ein paar Stellschrauben, die direkter beeinflussbar sind, aber genau die, die Qualität, Expertise, Vertrauenswürdigkeit von Seiteninhalten ausmachen, sind nicht dabei. Und was da schräg trainiert wurde, wird bis zur nächsten Runde schräg bewertet.

· Google verliert aber auch an anderen Ecken die Kontrolle…

…und das bedeutet, dass auch die Kunden die Kontrolle verlieren. Es ist nicht meine Kernkompetenz und ich bin grade in dem bereich sehr neugierig auf andere Leute Sichtweisen, aber ich gehe davon aus, dass grade im SEA-Bereich das zunehmende „Steuert das nicht händisch aus, lasst das die Ads-Automatik machen, die versteht die Seiten und die Targetings viel besser als ihr“-Nudging weniger darauf zurückzuführen ist, dass Google hofft, so mehr Werbeumsatz zu machen, sondern darauf, dass die händisch aussteuerbaren Optionen schwer im Schwinden begriffen sind.

Und nu?

Tja. Wie eingangs gesagt, das ist alles mal als starkes Rumgethese in den Raum gestellt, ich bin mir aber recht sicher, dass die Wirklichkeit in ungefähr der Richtung zu finden ist. Konkrete Learnings rausziehen scheint mir schwierig – man könnte sich überlegen, ob man die Trendschriftarten und -farben von bekanntermaßen als seriöslich klassifizierten Seiten mal als einen „Fällt da eine KI drauf rein?“-Bait ermitteln und nutzen will, aber naja, ernsthaft? Persönlich lässt mich das Ganze eine etwas entspanntere Haltung bei manchen mit Brettern vernagelten Rankings pflegen – es gibt die Toppositionen, die kriegt man halt erst nach ner nächsten Trainingssession der Google-RZs, und vorher kann man dreimal besser abliefern als die vor einem. Nicht, dass man sich zurücklehnt, himmel. Aber manchmal vielleicht einfach die restliche Zeit bis zum nächsten Coredance (Hm, Coredance? Oh, gibts schon) für was anderes nutzt, wenn man Aufwand X auf Seite Y geworfen hat und sich nichts rührt.

Ab davon: dass Google seine eigene Suche nicht mehr wirklich kontrollieren kann, ist einfach ein sehr schöner Gedanke. Wahrscheinlich grob vereinfacht, aber auch Holzschnitte haben ihre Ästhetiik, und die von diesem hier mag ich gerne.

3 Responses to Wie funktioniert der Google-Algorithmus? Ein paar starke Thesen.